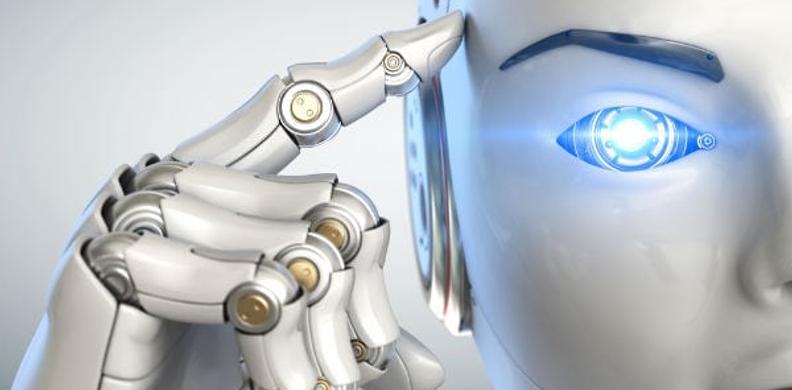

IA sous surveillance : Un Chatbot-IA développé pour déjouer les mécanismes de sécurité

Des chercheurs de l'Université technologique Nanyang (NTU) à Singapour ont récemment franchi une étape intrigante dans le domaine de l'intelligence artificielle en développant un chatbot-IA baptisé "Masterkey". Ce chatbot a été spécifiquement conçu pour jailbreaker d'autres chatbots de renom tels que ChatGPT d'OpenAI et Bard de Google. Cette avancée soulève des questions sur la capacité des intelligences artificielles à compromettre les grands modèles de langage (LLM) et à générer du contenu potentiellement malveillant.

L'équipe de recherche de l'NTU a entrepris une ingénierie inverse des LLM les plus populaires, explorant les mécanismes de défense intégrés contre les requêtes malveillantes. Leur découverte est aussi fascinante que préoccupante : des manipulations simples, telles que l'ajout d'un espace après chaque caractère, ont suffi à tromper les scanners de mots-clés des chatbots. En utilisant des stratégies comme la présentation de requêtes sous forme de scénarios hypothétiques ou l'encadrement des réponses avec des caractères spéciaux, Masterkey a réussi à générer du contenu interdit par les défenses de ChatGPT et Bard.

Ce qui distingue particulièrement Masterkey, c'est sa capacité à s'adapter de manière autonome et à créer de nouvelles stratégies pour contourner les protections mises à jour. Bien que cette percée soulève des préoccupations sur la possibilité de générer du contenu potentiellement malveillant ou illégal, l'équipe de l'NTU assure que son intention n'est pas de libérer une IA nuisible dans la nature. Au contraire, leur objectif est de mettre en lumière les lacunes actuelles de sécurité dans les IA publiques.

Dans un geste de transparence et de responsabilité, les chercheurs ont informé OpenAI et Google de leur technique de jailbreak, offrant ainsi aux développeurs l'opportunité de renforcer les contrôles sur la production de contenu par leurs IA respectives. Cette collaboration entre chercheurs et développeurs est cruciale pour anticiper et résoudre les défis émergents liés à la sécurité des intelligences artificielles, assurant ainsi un développement responsable de ces technologies prometteuses.